针对这个问题,我们主要从oVirt和OpenStack的定位来分析,然后结合个人/团队自身因素综合考虑。

首先我们来oVirt的定位,官网的介绍“oVirt is a free open-source virtualization solution for your entire enterprise.”,意思是oVirt是一个免费、开源的企业级虚拟化解决方案,官网中还有一个显眼的大标题“POWERFUL OPEN SOURCE VIRTUALIZATION”,叫“强大的开源虚拟化”。其实在早期的官网介绍中,还有一句话是“VMware vSphere的替代解决方案”,但是已经去掉了,可惜我没能截图保存下来,这样你应该清楚oVirt的定位了吧,oVirt就是冲着替代VMware vSphere去的,所以如果你之前在用或者打算要用VMware vSphere,那不妨试试oVirt。

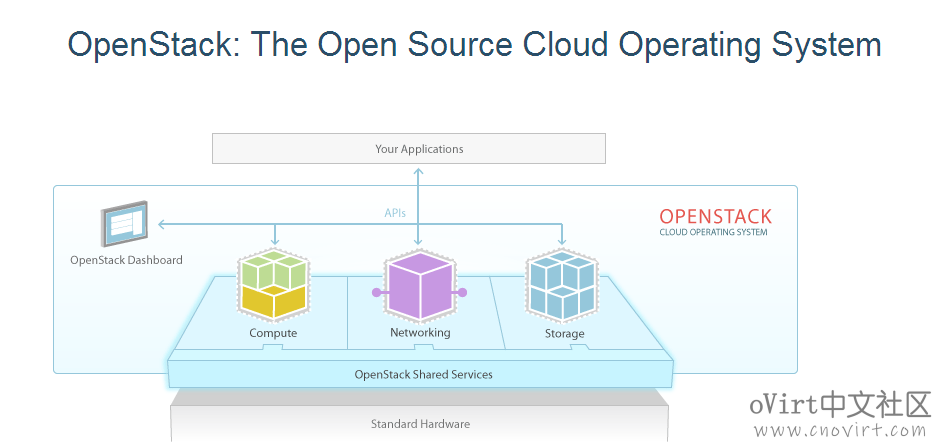

我们再来看OpenStack,官网的介绍“OpenStack is a cloud operating system that controls large pools of compute, storage, and networking resources throughout a datacenter, all managed and provisioned through APIs with common authentication mechanisms.”意思是OpenStack是一个云操作系统,能够控制数据中心中大量的计算池、存储和网络资源,并且通过api管理和实现身份认证。从字面意思上也可以看出OpenStack的定位是更大的云管理,侧重大规模。

通过早期我们对OpenStack和oVirt的对比研究,可以得出oVirt更侧重于对KVM虚拟化的细粒度管理,因为KVM项目也是RedHat主导的,所以一些KVM的特性最早能够在oVirt上得到体现和实践,通过oVirt Engine上的操作也可以看出对KVM虚机的配置非常丰富,同时oVirt产品化层面更成熟,例如具备成熟的集群HA方案,而OpenStack是没有内置成熟的HA及负载均衡调度一类的机制的,使得我们不得不去扩展它,相对于oVirt,OpenStack更像是一个工具包,需要进行组装来达到想要的效果,它可以给你提供大量的虚机,而你需要自己去考虑如何管理、使用、调度这些虚机。

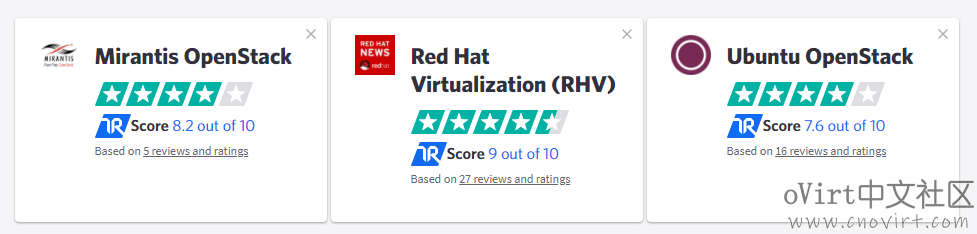

RedHat自身同时在维护oVirt和OpenStack这两个开源项目,而且RedHat在OpenStack项目上的贡献在企业贡献排名上排在第一位,几乎各项评价指标的排名都在第一位。对于RedHat自身的RHV和OpenStack商业版本,其定位是不同的,面向不同的客户需求,同时又有交叉,oVirt在存储和网络等功能组件方面都能够和OpenStack有机的集成和结合以实现更加丰富、复杂的功能。

综上,对于企业内建私有云,单集群规模在200台服务器以内,oVirt都是可以胜任的,当然你也可以建立多个集群,甚至建立多个数据中心。

另外oVirt和OpenStack项目的体量存在差异,业界有人称oVirt为小而美的OpenStack,从使用而言,如果要搞OpenStack的话建议有一个大体量的团队提供支撑保障,而对于oVirt,一个小团队足够了,如果你玩会了的话,一个人也可以,悠着点折腾。

从TrustRadius上关于RHV和OpenStack的评价对比看,oVirt/RHV还是比较受用户欢迎的:

PS:转载文章请注明来源:oVirt中文社区(www.cnovirt.com)

扫码加好友拉你进oVirt技术交流群!

您好,版主,使用NFS存储域传输巨慢,相信这个问题应该碰到的不少吧,应该怎么处理呢

内网kvm虚拟机的传输速度:108M/S

搭建的ovirt-engine主机的传输速度:108M/S

在ovirt-node上创建的kvm虚拟机:18M/S

这个是不是需要更改一些参数啊,之前没部署ovirt测试的NFS存储也正常,怀疑是是不是ovirt上层的一些参数做了限制?

据我了解NFS在oVirt生产环境里用做存储域的很少,就是因为性能很差,iSCSI比NFS要好,按理说应该不会单独针对NFS做限制的,没有意义啊,这个没有分析过。

你现在测试直接读写NFS存储和从虚机里读写速度差距多大?

就RH的官方推荐来看,RHV是优先推荐使用glusterfs的,哪怕单节点也比NFS性能好。

NFS除非要用freenas然后上zfs储存,否则不推荐使用。(freenas的iSCSI做不了hosted-engine的储存域,很奇怪)

差距挺大的,差50M/S左右,我昨天试了本地磁盘存储,然后创建了kvm虚拟机还是很慢。。。 到底什么鬼

你如果说是虚机内和虚机外的差距的话是另外一个层面的事,跟NFS不是一回事了,磁盘的空间类型(精简和预分配)、磁盘的接口类型(virtio还是ide),以及是否启用writeback等等都有影响

磁盘空间类型:预分配

磁盘得接口类型:virtio

是否启动witeback:这个我不太清楚,没记得有这一步操作

然后我测了一下kvm虚拟机的读写:

写:15M/S(不正常)

读:60M/S(正常)

这个写入不正常的话,哪些配置上的因素会导致啊~~~版主bb

虚机的操作系统是?接口类型选virtio-scsi,virtio的驱动要装。

如果对数据安全要求不高的话(突然断电有丢数据风险),可以把writeback打开,编辑虚机,自定义属性,viodiskcache配置成writeback。

系统是centos7.7 好 我是试一下看看

接口类型:virtio-scsi

开启了writeback

磁盘类型:预分配

操作系统:centos7.7

网卡类型是:VirtIO

存储是:本地磁盘

还有别的招嘛 版主bb~~~

这个不好说了,得分析下IO的路径,看卡在哪个环节了

这….排查好几天了,大家都没有碰到写入慢得问题吗。。

也挺怪得,读取正常,写入从80M/S缓慢的下降到20M/S

卡这好久了,您看您啥时候得空方便远程给看下不

换glusterfs呢,和NFS一样支持路径存储。

单节点这样一个命令就行了。(注意路径的所属权的对应权限)

gluster volume create ovirt IP:/data/ovirt

gluster volume start ovirt

Openstack是一个云平台管理的项目,它不是一个软件。这个项目由几个主要的组件组合起来完成一些具体的工作。Openstack是一个旨在为公共及私有云的建设与管理提供软件的开源项目。它的社区拥有超过130家企业及1350位开发者,这些机构与个人将 Openstack作为基础设施即服务资源的通用前端。Openstack项目的首要任务是简化云的部署过程并为其带来良好的可扩展性。本文希望通过提供必要的指导信息,帮助大家利用 Openstack前端来设置及管理自己的公共云或私有云。

OpenStack 是当今最具影响力的云计算管理工具——通过命令或者基于 Web 的可视化控制面板来管理 IaaS 云端的资源池(服务器、存储和网络)。它最先由美国国家航空航天局(NASA)和 Rackspace 在 2010 年合作研发,现在参与的人员和组织汇集了来自 100 多个国家的超过 9500 名的个人和 850 多个世界上赫赫有名的企业,如 NASA、谷歌、惠普、Intel、IBM、微软等。

[…] 概要: https://www.cnovirt.com/archives/2598oVirt与OpenStack之间如何选择 […]

请问ovirt和glusterfs结合有没有部署文档?

请参考本站oVirt超融合部署文档